Tempo di lettura stimato: 5'

Parliamo del tema del momento: l’intelligenza artificiale applicata al trattamento dei dati personali. Ma prima, un po’ di storia… No, non un po’ di storia sull’intelligenza artificiale in sé (di articoli su questo tema ce ne sono già abbastanza in giro per il web…). Intendo un po’ di storia sull’intelligenza artificiale e su di me.

Sì, perché, non sono sempre stato un Evangelist della privacy e un GDPR Jedi.

Nella mia prima vita, mi occupavo di intelligenza artificiale e reti neurali.

Nella mia prima vita, lavoravo nel campo dell’intelligenza artificiale e delle reti neurali

Cosa sono le reti neurali? Provo a spiegarlo in modo semplice. Le reti neurali fanno parte del machine learning (la macchina impara simulando l’apprendimento umano) e degli algoritmi di deep learning (la macchina impara a identificare oggetti e a eseguire compiti complessi, più lo fa, più diventa precisa). Si ispirano al cervello umano e imitano il modo in cui i neuroni cerebrali inviano segnali.

Bene. Da lì, poi, è nata la mia passione per altre cose. Ma è dalle reti neurali e dall’AI (Artificial Intelligence) che sono partito. Adesso ci sto ritornando, perché si ricomincia a parlare di intelligenza artificiale. E dato che “io c’ero”, posso dire che sull'intelligenza artificiale, soprattutto quella deduttiva, gli italiani e i giapponesi sono avanti anni luce rispetto agli americani. Per intenderci, quando in Italia e in Giappone si lavorava già sulle reti neurali, negli USA si ragionava ancora sulla statistica e sulla stocastica, cioè, per semplificare al massimo, si operava con modelli basati sul calcolo delle probabilità. Avevano i “computer grossi”, usavano “la potenza di calcolo” e facevano simulazioni. Poi hanno capito che così non poteva funzionare e sono tornati indietro.

Fine della parentesi storica.

Fine della parentesi storica.

Riprendiamo il discorso su intelligenza artificiale e trattamento dei dati personali.

Come sappiamo, a un certo punto del 2022, OpenAI ha lanciato ChatGPT.

Milioni e milioni di persone hanno iniziato a usarlo.

Tutti a chattare con una cosa mai vista prima. Bellissima. Potentissima. Praticamente un’astronave in mano a un bambino. E infatti…

A un certo punto, il Garante privacy ha bloccato ChatGPT in Italia

Il Garante ha bloccato ChatGPT e tutti - giornali, influencer, tiktokkari, una marea di persone - hanno iniziato a dire "Ecco, ci facciamo riconoscere... Il Garante italiano ha bloccato ChatGPT... Siamo i soliti italiani, ci passeranno davanti..."

Apriti cielo.

Allora, chiariamo una cosa: è interessantissimo ChatGPT, ma il fatto che ci abbiano messo miliardi di dollari, non presuppone che possano fare quello che vogliono, soprattutto in una situazione di palese confusione. Non si capiva quali dati venissero trattati, come, perché.

Il Garante ha solo alzato la mano per dire a OpenAI: "Scusa, per capire, ma che dati tratti?"

Trovo assolutamente corretto che intervenga chi deve tutelare i diritti di persone - noi – che non sono capaci di capire la differenza tra un foglio di calcolo e una chatbot che impara da quello che gli scriviamo. Bisogna che qualcuno ci aiuti dicendo "Guarda, ti chiedo scusa, questa è una tecnologia nuova, me la spieghi che cerchiamo di gestirla?”

Per me, la decisione del Garante era assolutamente coerente.

E infatti, guarda caso - e l'ho trovato tra l'altro molto azzeccato -, OpenAI/ChatGPT ha iniziato a fare pubblicità per spiegarci che, se vogliamo, possiamo far sì che le nostre informazioni non vengano usate per insegnare alle loro reti. Spiega come comportarsi.

Bene. Non voglio farne una questione di nazionalismo, perché non è questo il punto. Il punto è che, invece di essere “i soliti italiani”, siamo stati i primi ad alzare la mano e a far notare che qualcosa non tornava. Siamo stati i primi e abbiamo agito in maniera assolutamente corretta, con quella che è la logica del GDPR, cioè, tutelare i diritti degli interessati.

Perché, se l’interessato è Peppino, che non capisce la differenza tra usare una app che ti spiega come fare le ricette e uno strumento "potenzialmente pericoloso", è chiaro che abbiamo un problema.

Quando l’interessato è Peppino, che sullo smartphone non sa quali app ha installato e chiede aiuto ai nipoti…

Prendiamo il caso di un utente medio/medio-basso, nel senso che ha poca dimestichezza con la tecnologia: Peppino (un personaggio immaginario). Peppino ha uno smartphone e crede ancora che sia solo un telefono. Ci ha messo delle app, ma non sa a cosa gli servono. Peppino, quando ha dei problemi col telefono, chiede aiuto ai suoi nipoti, perché sono nativi digitali (della questione “nativi digitali” abbiamo già parlato in questo blog, se ti interessa puoi approfondire leggendo due articoli: GDPR e minori nel contesto digitale e GDPR e tutela dei minori: il ruolo delle piattaforme).

Di Peppino ce ne sono tantissimi.

Probabilmente conosci un Peppino anche tu.

Anch’io, per certe cose, sono stato un Peppino.

È un dato di fatto.

Bene. Ma con Peppino (e non solo con lui) c’è un problema.

Il problema è legato al fatto che le novità ci piacciono tanto, ma devono essere attenzionate e gestite con consapevolezza, perché dobbiamo avere un’idea chiara di quello che ci propongono.

Altrimenti usiamo degli strumenti “potenzialmente pericolosi” senza rendercene conto.

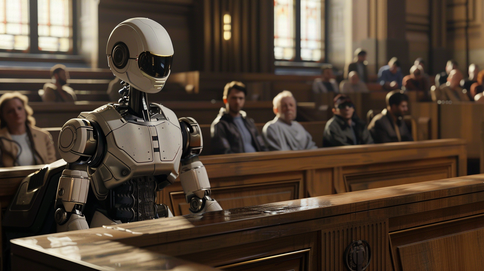

I sistemi di intelligenza artificiale sono come delle macchine da Formula 1, per guidarle, serve la patente. Non è che domani io vado a Imola, mi metto al volante della macchina da corsa che trovo e parto…

Ci serve la “patente di guida”

Abbiamo bisogno della patente di guida, altrimenti succede come a Peppino (sempre lui, il nostro personaggio immaginario) che un giorno incontra un amico che vende pillole dimagranti… Mi sono immaginato questo dialogo:

Amico: “Guarda, con questa pillolina qui dimagrisci 50 kg in un mese...”

Peppino: “Fantastico. Ma cosa c’è dentro?”

Amico: “Eh, ci abbiamo messo 1 miliardo di euro… è stata studiata dai migliori biologi del mondo..."

Peppino: “Ah, allora la compro! Dove la posso trovare?”

Amico: “La compri su internet, su un sito che ha sede in Nigeria” (o in Russia o in Colombia… o anche in Italia, magari, su un sito che non è stato autorizzato… diciamo in un posto dove non hai la certezza che siano stati fatti dei controlli e che il farmaco sia stato approvato).

Adesso la domanda la faccio a te, che in questo momento stai leggendo questo articolo: una medicina così, di cui non sai da dove proviene, come è fatta, cosa c’è dentro, che nessuno ha certificato come conforme alle norme. Una pillolina così, la compreresti?

Io no. E neanche Peppino.

Allora perché molti usano strumenti che potenzialmente sono pericolosi?

Perché manca la consapevolezza.

Dobbiamo avere la consapevolezza per capire se possiamo usare o no uno strumento potentissimo.

Ce l’abbiamo? Bene.

Non l’abbiamo? Allora, stiamo giù e cerchiamo di costruirla questa consapevolezza.

RIPRODUZIONE RISERVATA. Ne è consentito un uso parziale, previa citazione della fonte.